Les stratégies de recherche dépendent de nombreux facteurs qu’il faut savoir prendre en compte

Pour faire suite à notre article sur les moteurs de recherche, nous avons téléchargé Ecommerce User Experience Series – Search, étude très complète de Norman Nielsen Group (NNG) sur le même sujet. Un travail très bien fait qui répète sans doute quelques évidences, mais rentre dans le détail de nombreux sites pour bien comprendre comment optimiser l’ergonomie d’un moteur de recherche sur les sites de ecommerce. Point notamment, passionnant, la manière dont les internautes utilisent un moteur de recherche. Il s’avère que les stratégies de recherche sont très variables et les usages très différents, selon l’historique du parcours client, la profondeur de gamme, la largeur de l’offre, mais aussi de la qualité du référentiel produit. Pour y voir plus clair, voici les principales stratégies recensés par NNG.

Principales stratégies de recherche

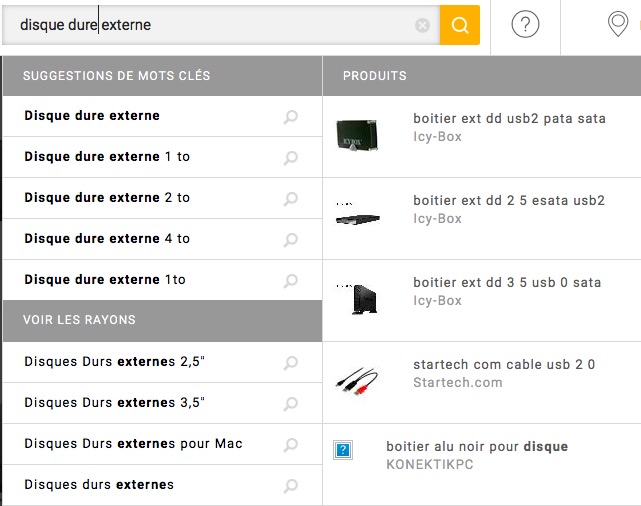

Un des premiers comportements est le besoin de l’utilisateur de se rendre compte rapidement de ce qu’il va pouvoir trouver sur le site. Ce comportement à mettre en parallèle avec les utilisateurs qui regardent le menu de navigation pour déterminer le contenu global du site. Ce comportement est plutôt fréquent lorsque les utilisateurs arrivent pour la première fois sur un site.

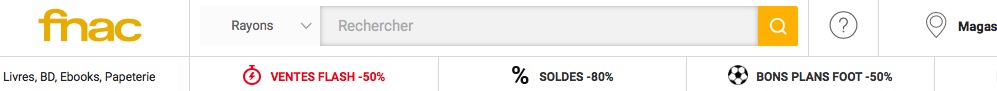

De toute évidence, un des comportement les plus courants est la recherche rapide d’un produit. Chercher un produit par mot clé quand l’arborescence produit est beaucoup trop grande (sur un site comme Cdiscount, par exemple) entraîne forcément un sentiment d’impuissance qui amène l’utilisateur à essayer d’aller plus vite au but en utilisant la puissance du moteur de recherche.

Ce comportement s’effectue aussi pour les gens cherchant des produits qui pourraient ne pas apparaître immédiatement en haut des résultats de recherche. C’est à l’heure actuelle, la raison d’être principale du moteur de recherche, selon moi.

Autre motif d’utilisation du moteur de recherche, la frustration de ne pas avoir trouvé ce que l’on cherchait en utilisant l’arborescence. Ce comportement est typique et permet de « sauver la mise » au site si le rangement de son offre est mauvais.

Mais le moteur de recherche est aussi utilisé lorsque l’utilisateur sait exactement ce qu’il veut. Plutôt que de passer par l’arborescence, alors celui-ci tapera le nom spécifique du produit pour le retrouver. On devine que ce comportement se déroule plutôt en fin de processus d’achat dans un parcours d’achat typique.

Autre stratégies :

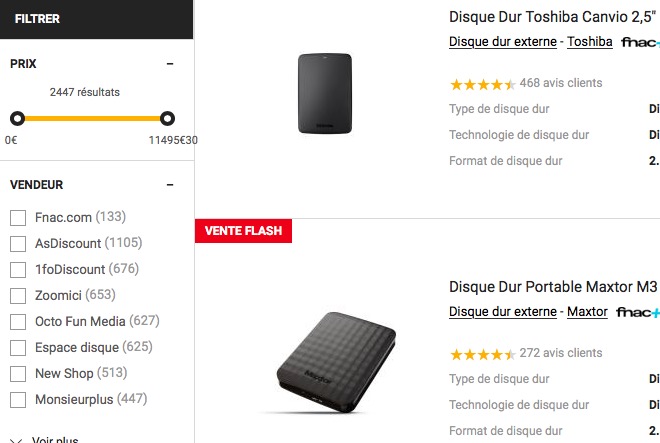

Recherche par critère. Parfois l’utilisateur ne sait pas exactement quel produit, il veut, mais il sait quel caractéristique ce produit doit avoir. Par exemple, pour un disque dur, il tapera sa capacité plutôt que son intitulé. C’est évidemment une façon de chercher à laquelle un bon moteur de recherche devra savoir répondre.

Recherche par manque : si un utilisateur ne trouve pas dans la description d’un produit une information particulière, alors il ira faire une recherche sur le point manquant. C’est ce que j’appelle une recherche par manque.

Recherche par défaut : dans le cas d’une recherche par filtres, il est possible que l’utilisateur soit déçu par les résultats et ait l’impression que le site ne lui ait pas renvoyé tous les résultat. Dans ce cas aussi, il tapera les critères du filtre pour être certain qu’aucune information ne lui a été « dissimulée ».

Recherche par rétrécissement. Ce genre de recherche n’est possible que dans certains sites où il est possible d’affiner l’affichage d’une catégorie en faisant une recherche spécifique à l’intérieur. Ce type de recherche apparait comme une sorte de réponse à une déception dans la navigation par catégorie.

Recherche rapide. Dernier cas concernant les produits, cette recherche consiste simplement à taper le nom d’un produit qu’on a déjà vu au cours d’une visite précédente.

Enfin, il existe une autre raison pour utiliser le moteur de recherche d’un site. Il s’agit de la recherche d’information autre qu’un produit.

Comprendre les différents comportements de recherche devrait permettre d’offrir des réponses plus adaptées et bonifiantes pour le taux de transformation

Outre ces manières de rechercher, l’étude de NNG nous apprend quels sont les termes essentiellement utilisés pour faire une recherche, ainsi, en plus de cela le nombre de caractères et le nombre de mots des requêtes. On ne sera pas étonné que ce nombre ne dépasse pas 2,5 mots en moyenne. Curieusement, l’étude ne dit pas si il y a une différence entre recherche sur smartphone et écran d’ordinateur, ce qui devrait nécessairement avoir une conséquence sur cette donnée.

L’important, dans cette information, est de retenir que le moteur répond à de nombreux besoins qui ne sont souvent pas pris en compte dans l’ergonomie ou les contenus des pages de résultat. En effet, il serait tout à fait possible en analysant ces différents comportements de pouvoir modifier l’apparence des contenus, leur ordre d’affichage ou même d’autres choses comme le prix ou le type d’information à mettre en avant. Ce sont de véritables opportunités à saisir pour bonifier son taux de transformation.

Photo de l’article par Marten Newhall sur Unsplash

Photo de l’illustation par Taras Shypka sur Unsplash